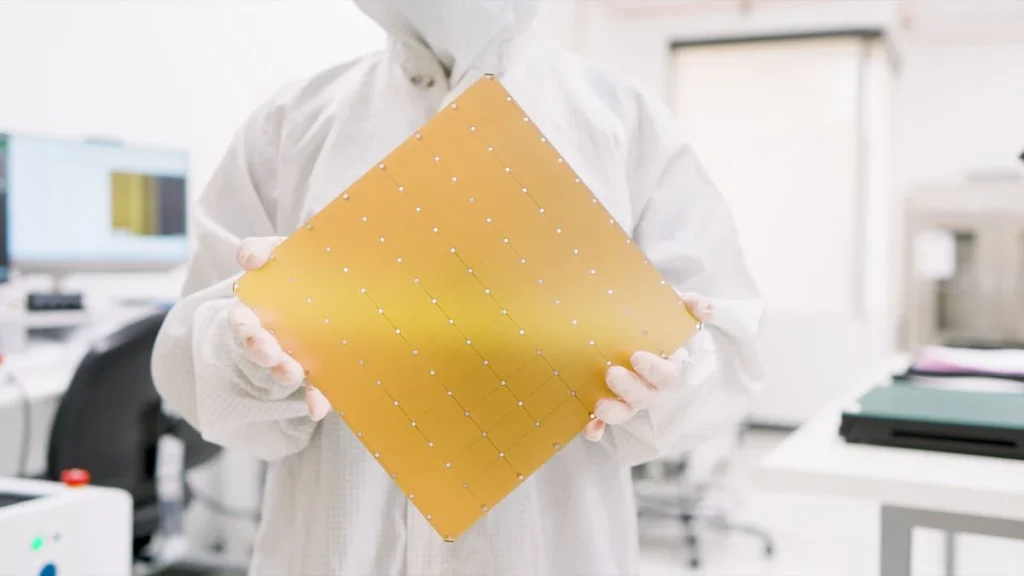

شرکت «Cerebras Systems» که تو کالیفرنیاست از جدیدترین تراشه هوش مصنوعیش به اسم Wafer Scale Engine WSE-3 پرده برداشته که دارای تعداد چشمگیر ۴ تریلیون ترانزیستوره. عملکرد این تراشه دو برابر بیشتر از مدل قبلی، Cerebras WSE-2، هست که خودش قبلاً رکورد سریعترین تراشه رو شکسته بود. سیستمی که از WSE-3 استفاده کنه میتونه در عرض یک روز مدلی با ۷۰ میلیارد پارامتر رو تنظیم کنه (این کار رو اصطلاحاً fine-tune کردن مدل میگن)

مدلهای هوش مصنوعی مثل GPT که دنیا رو حسابی تکون دادن و قابلیتهای خیلی بالایی دارن. بااینحال، شرکتهای فناوری میدونن که این مدلهای هوش مصنوعی هنوز خیلی ابتدایی هستن و برای تأثیرگذاری اساسی تو بازار به تکامل بیشتری احتیاج دارن. برای این کار لازمه که این مدلها با مجموعه دادههای خیلی بزرگتری آموزش داده بشن. این باعث میشه که زیرساختهای خیلی قویتری هم نیاز باشه.

شرکت تولیدکننده قطعات کامپیوتری، انویدیا «Nvidia»، بهخاطر تقاضایی که برای چیپهای جدید، بزرگتر، و قویتر وجود داره، کلی پیشرفت کرده. H۲۰۰، که مهمترین محصول این شرکته و بهصورت تجاری هم در دسترسه، برای آموزش مدلهای هوش مصنوعی استفاده میشه و ۸۰ میلیارد ترانزیستور داره. اما باز هم Cerebras هدف داره با WSE-3 عملکرد رو ۵۷ برابر بیشتر کنه!

مشخصات فنی CS-3

WSE-3 از معماری ۵ نانومتری استفاده میکنه و طوری طراحی شده که ۹۰۰٬۰۰۰ هسته (core) بهینه شده برای پردازش دادههای هوش مصنوعی رو توی سیستم CS-3 تأمین میکنه که ابرکامپیوتر هوش مصنوعی ساختهشده توسط همین شرکته. این ابرکامپیوتر ۴۴ گیگابایت SRAM روی بُرد داره. میتونه ۲۴ تریلیون پارامتر رو توی یه فضای حافظه منطقی واحد ذخیره کنه بدون اینکه لازم باشه پارتیشنبندی یا شکسته بشن. (این کار رو اصطلاحاً re-factoring میگن). هدف از این کار اینه که مراحل توسعه و آموزش مدل «به طرز چشمگیری سادهتر» بشه و بهرهوری کسی که داره باهاش کار میکنه افزایش پیدا کنه.

ظرفیت حافظه خارجی CS-3 رو بسته به نیاز مدل هوش مصنوعی که داره آموزش داده میشه میشه از ۱٫۵ ترابایت تا ۱٫۲ پتابایت تغییر داد. این کار برای آموزش مدلهایی انجام میشه که تا ۱۰ برابر بزرگتر از GPT-4 یا Gemini هستن. این شرکت ادعا میکنه که آموزش دادن یه مدل هوش مصنوعی با یک تریلیون پارامتر (هزار میلیارد) روی CS-3 به آسونی آموزش یه مدل با یک میلیارد پارامتر روی پردازنده گرافیکی معمولیه.

هرجا که لازم باشه میشه CS-3 رو طوری تولید کرد که با نیازهای شرکتها یا مراکزی که با دادههای خیلی حجیم سروکار دارن سازگار باشه. اگه ۴ تا سیستم به این صورت وجود داشته باشه، CS-3 میتونه مدلهای هوش مصنوعی متشکل از ۷۰ میلیارد پارامتر رو در طول یک روز fine-tune کنه. تازه اگه این سیستم رو به ۲۰۰۰ عدد برسونین، میتونه یه مدل هوش مصنوعی به اسم Llama رو با ۷۰ میلیارد پارامتر از پایه طراحی کنه اونهم فقط در عرض یک روز!

WSE-3 کجا استفاده میشه؟

تو دورانی که مصرف انرژی پردازندههای گرافیکی توی هر نسل دوبرابر میشه، شرکت Cerebras داره کاری میکنه که جدیدترین تراشه اونها ضمن اینکه اندازه یا مصرف انرژیش بیشتر نمیشه، عملکردش دو برابر بشه.

تراشه مخصوص هوشمصنوعی اونها برای آموزشدادن مدلهای زبانی بزرگ (LLM) به ۹۷ درصد کد کمتر در مقایسه با پردازندههای گرافیکی نیاز داره. مثلاً یه مدل استاندارد به بزرگی GPT-3 رو فقط با ۵۶۵ خط کد میشه درست کرد.

Cerebras برنامه داره تا WSE-3 رو در تأسیسات زیرمجموعههای دو تا از همکارای قدیمیش یعنی آزمایشگاه ملی آرگون (Argonne National Laboratory) و کلینیک مایو (Mayo Clinic) پیاده کنه تا بتونه تحقیقات و پژوهش رو با امکانات بهتری توی این مراکز گسترش بده.

Cerebras همینطور اعلام کرده که داره با شرکتی به اسم G۴۲ که شریکشون بوده تو ساخت ابرکامپیوترهای هوشمصنوعی سری Condor Galaxy به اسم CG-1 و CG-2 در کالیفرنیا، حالا روی ساخت CG-3 کار میکنن که یکی از بزرگترین ابرکامپیوترها در دنیاست. وقتی CG-3 آماده بشه، از ۶۴ تا واحد CS-3 تشکیل شده و ۸ اگزافلاپس «exaFLOPS» قدرت محاسباتی خواهد داشت.

کیریل او تیموف، مدیر ارشد فناوری G۴۲، توی یه اطلاعیه مطبوعاتی گفت: «همکاری استراتژیک ما با Cerebras توی پیشرفت و نوآوری توی G۴۲ نقش مهمی داشته و باعث میشه به پیشرفت انقلاب هوش مصنوعی توی مقیاس جهانی سرعت ببخشیم».