همهچیز از ادعای عرفان عظیمی شروع میشه که روز یکشنبه، ۵ می به Rand Fishkin ایمیل میزنه و میگه به اسناد API داخل بخش جستجوی گوگل دسترسی داره و حتی این اسناد توسط کارمندان سابق گوگل هم تایید شده. بیش از ۲۵۰۰ صفحه اسناد API حاوی ۱۴۰۱۴ ویژگی «ویژگیهای API» که به نظر میرسه از «Content API Warehouse» داخلی گوگل میاد. بر اساس تاریخچه commit این سند، این کد در ۲۷ مارس ۲۰۲۴ به GitHub آپلود شده و تا ۷ می۲۰۲۴ حذف نشده. این اسناد رو در ادامه بررسی میکنیم.

آپدیت: در تاریخ ۳۰ می ۲۰۲۴ گوگل صحت این اسناد را به صورت رسمی تایید کرد.

NavBoost چیست

تو سالهای اولیه، تیم جستجوی گوگل نیاز به دادههای کامل clickstream «هر URL که توسط یه مرورگر بازدید میشه» برای رصد کاربران وب و بهبود کیفیت نتایج موتور جستجوی خودش تشخیص داد.

سیستمی به نام «NavBoost» «که توسط معاون جستجو، پاندو نایاک، در شهادت پرونده وزارت دادگستری ذکر شده» در ابتدا دادهها رو از Toolbar PageRank گوگل جمعآوری کرد و تمایل به دادههای بیشتر clickstream به عنوان انگیزه اصلی برای ایجاد مرورگر کروم «راهاندازی شده در سال ۲۰۰۸» عمل کرد.

در اصل یکی از ایدههای ساخت مرورگر کروم همین جمعآوری دیتاها برای بهبود نتایج بود.

NavBoost میاد از تعداد جستجوهای یک کلمه کلیدی برای شناسایی میزان ترند بودن و یا تعداد کلید روی نتایج جستجو استفاده میکنه، از طرفی گوگل از تاریخچ کوکیها به عنوان یه ابزار برای مبارزه با اسپم استفاده میکنه.

NavBoost همچنین امتیازی برای هدف کاربر از کوئریها در نظر میگیره. به عنوان مثال، آستانههای خاصی از توجه و کلیکها روی ویدیوها یا تصاویر رو برای اون کوئری و کوئریهای مرتبط با NavBoost فعال میکنه.

گوگل کلیکها و تعامل در جستجوها بررسی میکنه. به عنوان مثال، اگه بسیاری از کاربران «سروش احمدی» رو جستجو کنن و Rahdigital رو پیدا نکنن، و بلافاصله کوئری خودشون رو به «Rahdigital » تغییر بدن و روی Rahdigital.ir در نتیجه جستجو کلیک کنن، از این پس نتیجه Rahdigital با جستجوی «سروش احمدی» بیش از پیش نمایش داده میشه.

در واقع گوگل به دنبال این هست که هدف کاربر رو متوجه بشه و اون رو در رتبهبندی و نتایج خودش قرار بده.

دادههای NavBoost برای ارزیابی کیفیت کلی یه سایت استفاده میشه که احتمالا همونچیزی باشه که اکثر سئوکارها بهش الگوریتم «پاندا» میگن.

سایر عوامل جزئی مانند جریمه برای نامهای دامنهای که دقیقاً با کوئریهای جستجوی بدون برند مطابقت دارن (مثلاً mens-luxury-watches.com یا buy-mobile.net)، از همین گروه هستن، البته احتمالا روی تککلمهای تاثیر زیادی نداشته باشن، مثل mobile.com و …

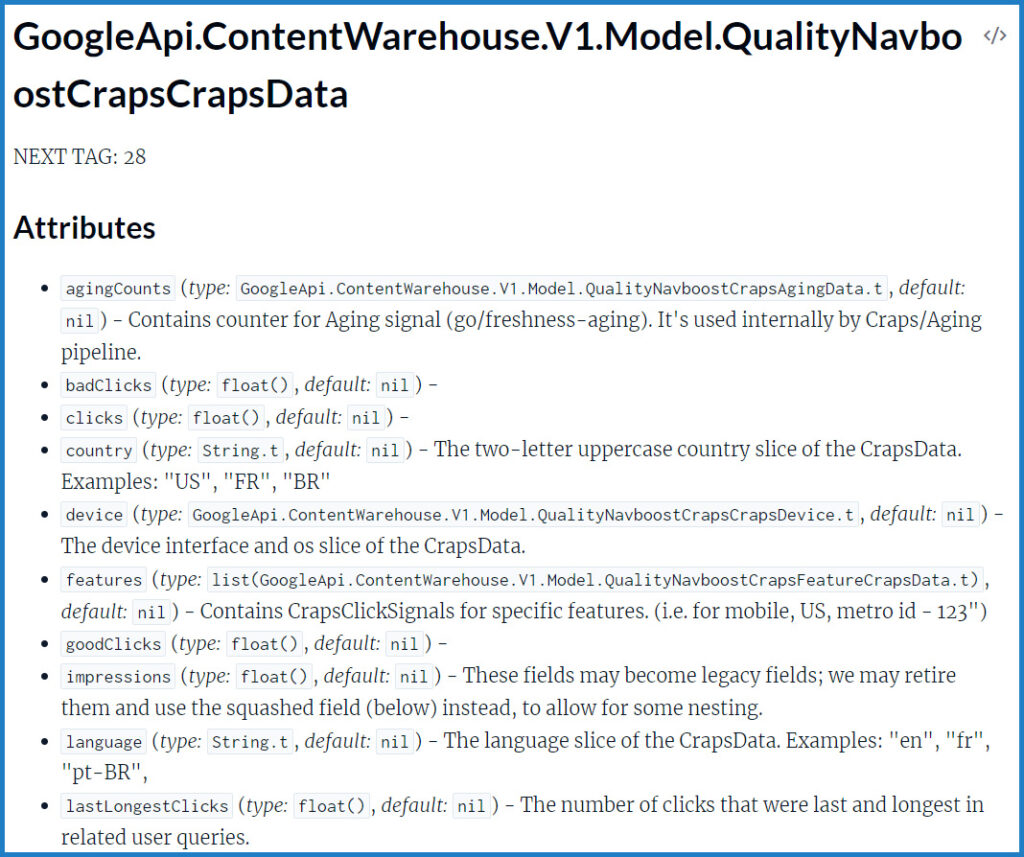

NavBoost دادههای کلیک رو با در نظر گرفتن سطوح کشور و ایالت/استان و همچنین استفاده از موبایل در مقابل دسکتاپ، منطقهبندی میکنه. با این حال، اگه گوگل فاقد داده برای مناطق یا user-agentهای خاص باشه، ممکنه این فرآیند رو به طور جهانی برای نتایج کوئری اعمال کنه.

در طول همهگیری کووید-۱۹، گوگل از لیستهای سفید برای وبسایتهایی که میتونستن در نتایج جستجوهای مربوط به کووید ظاهر بشن، استفاده میکرد. «منظور وبسایتهای مفید در مورد کرونا هست»

یعنی الگوریتمهای اختصاصی وجود داشت که بازدید بیشتری به وبسایتهای موجود در لیست سفید میداد تا بیشتر در نتایج جستجو باشن.

و البته که اینها فقط نوک کوه یخ هستن.

ادعاهای خارقالعاده نیاز به شواهد خارقالعاده دارن. و در حالی که برخی از این موارد با اطلاعات فاش شده در پرونده Google/DOJ همپوشانی دارن.

در مورد اسناد

این اسناد چیزهایی مثل وزن عناصر خاص در الگوریتم رتبهبندی جستجو رو نشون نمیده و همچنین ثابت نمیکنه که از چه عناصری در سیستمهای رتبهبندی استفاده میشه. اما، جزئیات باورنکردنی در مورد دادههایی که گوگل جمعآوری میکنه رو نشون میده.

یه نمونه از اظهارات نمایندگان گوگل «مت کاتس، گری ایلیز و جان مولر» که استفاده از سیگنالهای کاربر مبتنی بر کلیک رو در رتبهبندیها در طول سالها رد میکنن و البته این اسناد نشون میده گوگل به شدت بر دریافت این دادهها متکی هست.

حتی قبلتر من تلاش کردم از طریق یک کارشناس سئواز جانمولر سوال کنم که گوگل چهدادههایی رو از کروم دریافت میکنه و جان مولر هم سعی کرد جواب خودشو مقداری سر بسته ارائه بده.

آیا میتوانیم به این اسناد اعتماد کنیم

قدم مهم بعدی در این فرآیند، تأیید صحت اسناد Content API Warehouse هست. برای این کار Rand Fishkin با چند تا از دوستانش که قبلا توی گوگل کار میکردن و الان گوگلر «کارمند با سابقه گوگل» هستن تماس میگیره و این نظارت رو از اونا میشنوه:

- «من وقتی اونجا کار میکردم به این کد دسترسی نداشتم. اما این قطعاً به نظر قانونی میاد.»

- «این همه ویژگیهای یه API داخلی گوگل رو داره.»

- «این یه API مبتنی بر جاوا هست. و یه نفر زمان زیادی رو صرف رعایت استانداردهای داخلی گوگل برای مستندسازی و نامگذاری کرده.»

- «برای اطمینان به زمان بیشتری نیاز دارم، اما این با اسناد داخلی که من باهاش آشنا هستم مطابقت داره.»

- «هیچ چیزی که من تو یه بررسی مختصر دیدم نشون نمیده که این چیزی جز قانونی باشه.»

بعد، برای اطمینان بیشتر با مایک کینگ که از سئوکارهای معروف و فنی هست تماس میگیره و اونم تایید میکنه که میتونه این اسناد درست باشه.

اهمیت اسناد

وقتی من سئو رو تو سال ۱۳۸۹ شروع کردم، شفافیت بیشتری وجود داشت، مثلا میدونستیم اگه تولید محتوای خوبی داشته باشیم همهچیز تمامه و میتونیم کمتر از چند هفته به ورودی گوگل چند ده هزاری برسیم، با گذشت زمان رتبه گرفتن سختتر شد و به نظر هم میرسه که گوگل بیشتر به جعبه سیاه تبدیل شده.

چرا که میدونید امروز فقط داشتن یک محتوای خوب یا رفع نیاز کاربر کافی نیست و باید دست به کارهایی بزنید که گوگل بارها اونهارو در صحبتهاش رد میکنه.

این اسناد میتونه بخشی از همین تناقضات گوگل باشه و به همین دلیل اهمیت زیادی دارن، این اهمیت در جهت یادگیری ما از گوگل و البته فشار به گوگل برای تغییرات هست.

Content API Warehouse گوگل چیست؟

وقتی به این حجم عظیم از اسناد API نگاه میکنیم، اولین مجموعه سوالات منطقی ممکنه این باشه: «این چیه؟ برای چی استفاده میشه؟ چرا اصلاً وجود داره؟»

به نظر میرسه که این نشت از GitHub اومده و قابل قبولترین توضیح برای افشای اون با چیزی که منبع میگه مطابقت داره: این اسناد به طور ناخواسته و برای مدت کوتاهی عمومی شدن «بسیاری از لینکهای موجود در مستندات به مخازن خصوصی GitHub و صفحات داخلی در سایت شرکتی گوگل اشاره میکنن که به ورود به سیستم خاص با اعتبارنامه گوگل نیاز دارن». در طول این دوره عمومی که احتمالاً تصادفی بوده و بین مارس و می ۲۰۲۴ اتفاق افتاده، اسناد API در Hexdocs «که مخازن عمومی GitHub رو فهرست میکنه»

طبق گفته منابع که قبلاً تو گوگل کار میکردن، چنین اسنادی تقریباً در هر تیم گوگل وجود داره و ویژگیها و ماژولهای مختلف API رو توضیح میده تا به کسانی که روی یه پروژه کار میکنن کمک کنه تا با عناصر داده موجود آشنا بشن. این نشت با موارد دیگه در مخازن عمومی GitHub و در مستندات Google Cloud API مطابقت داره، با استفاده از همون سبک نشانهگذاری، قالببندی، و حتی نامها و مراجع فرآیند/ماژول/ویژگی.

چقدر میتونیم مطمئن باشیم که گوگل از همه چیزهایی که در این اسناد API توضیح داده شده استفاده میکنه؟

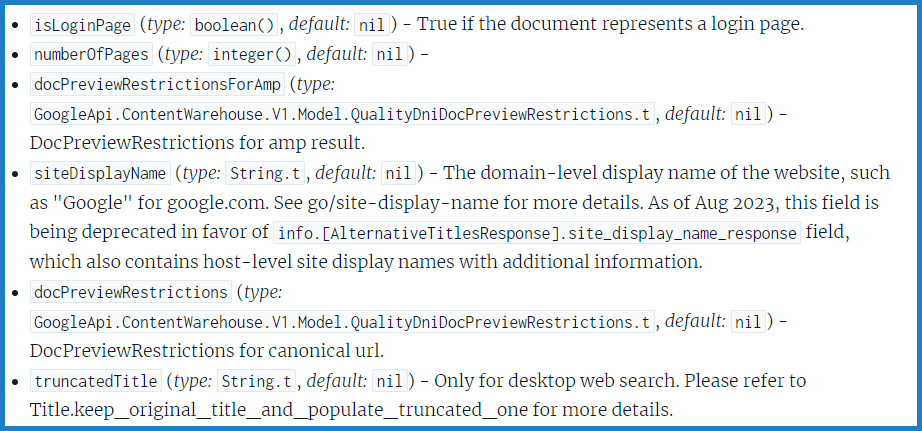

گوگل ممکنه برخی از اینهارو بازنشسته کرده باشه، یا توی پروژهای داخلی استفاده میکنه که هرگز عمومی نشده باشن، با این حال در این اسناد به ویژگیهای منسوخ شده و یادداشتهای خاصی اشاره شده که نشون میده دیگه نباید از اونها استفاده بشه. این نشون میده اونهایی که با چنین جزئیاتی علامتگذاری نشدن، تا زمان نشت در مارس ۲۰۲۴ همچنان در حال استفاده و فعال بودن.ما همچنین نمیتونیم با اطمینان بگیم که آیا نشت ماه مارس مربوط به آخرین نسخه این اسناد هست یا خیر. جدیدترین تاریخی که میتونم تو اسناد API پیدا کنم، آگوست ۲۰۲۳ هست:

متن مربوطه میگه:

«یک نام نمایشی یک سایت مثلا «راهدیجیتال» برای «rahdigital.ir». برای جزئیات بیشتر به go/site-display-name مراجعه کنید. از آگوست ۲۰۲۳، این فیلد به نفع فیلد info. [AlternativeTitlesResponse]. site_display_name_response که شامل نامهای نمایشی سایت در سطح میزبان با اطلاعات اضافی نیز هست، منسوخ میشه.»

شماره ۱: Navboost و استفاده از کلیکها، CTR، لینکهای طولانی در مقابل کوتاه، و دادههای کاربر

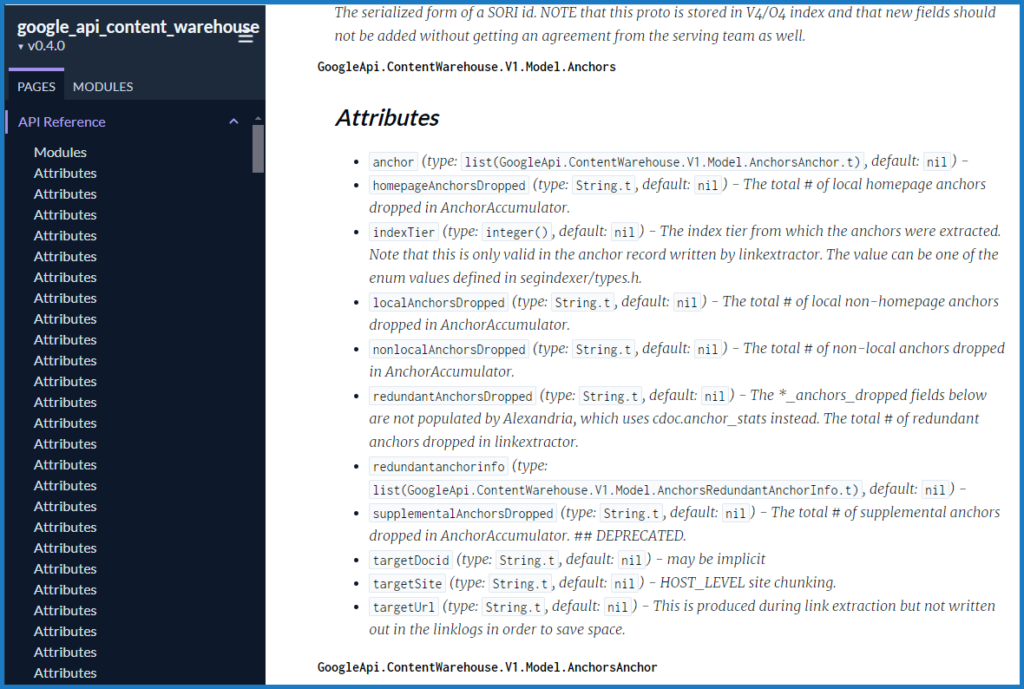

چندین ماژول در این اسناد به ویژگیهایی مثل «goodClicks»، «badClicks»، «lastLongestClicks»، impressions، squashed، unsquashed و unicorn clicks اشاره میکنن. اینها به Navboost و Glue گره خوردن، دو کلمهای که ممکنه برای افرادی که شهادت گوگل در وزارت دادگستری رو بررسی کردن آشنا باشه. در اینجا یه بخش مرتبط از بازجویی کنت دینتزر، وکیل وزارت دادگستری، از پاندو نایاک، معاون جستجو در تیم کیفیت جستجو، آورده شده:

- سوال: پس یادآوری کنید، navboost به سال ۲۰۰۵ برمیگرده؟

- پاسخ: یه جایی تو اون محدوده. حتی ممکنه قبل از اون باشه.

- سوال: و آپدیت شده. همون navboost قدیمی نیست که اون موقع بود؟

- پاسخ: نه.

- سوال: و یکی دیگه هم glue هست، درسته؟

- پاسخ: Glue فقط یه اسم دیگه برای navboost هست که شامل همه ویژگیهای دیگه صفحه میشه.

- سوال: درست. میخواستم بعداً به اونجا برسم، اما میتونیم الان این کار رو انجام بدیم. Navboost نتایج وب رو انجام میده، درست مثل همون چیزی که بحث کردیم، درسته؟

- پاسخ: بله.

- سوال: و glue همه چیزهای دیگه روی صفحه که نتایج وب نیستن رو انجام میده، درسته؟

- پاسخ: درسته.

- سوال: اونا با هم به پیدا کردن چیزها و رتبهبندی چیزهایی که در نهایت در SERP ما نشون داده میشن کمک میکنن؟

- پاسخ: درسته. هر دو سیگنالهایی برای اون هستن، بله.

یه خواننده باهوش این اسناد API متوجه میشه که شهادت آقای نایاک با چیزهایی که در اسناد هست مطابقت داره و از طرفی با حق ثبت اختراع گوگل هم همسو هستن.

- ماژول دادههای Quality Navboost

- تقسیمبندی جغرافیایی دادههای Navboost

- سیگنالهای کلیک در Navboost

- نمایشها و کلیکهای Data Aging

به نظر میرسه که گوگل راههایی برای فیلتر کردن کلیکهایی که نمیخوان در سیستمهای رتبهبندیشون حساب کنن، و گنجوندن اونهایی که میخوان، داره. به نظر میرسه که اونا همچنین طول کلیکها (یعنی pogo-sticking – وقتی یه جستجوگر روی یه نتیجه کلیک میکنه و سپس به سرعت دکمه برگشت رو کلیک میکنه، چون از پاسخی که پیدا کرده راضی نیست) و impressionها رو هم اندازهگیری میکنن.

قبلاً مطالب زیادی در مورد استفاده گوگل از دادههای کلیک نوشته شده، بنابراین من این نکته رو بیشتر توضیح نمیدم. چیزی که مهمه اینه که گوگل ویژگیهایی رو برای اون اندازهگیری نامگذاری و توصیف کرده که کم هم نیستن.

شماره ۲: استفاده از clickstreamهای مرورگر کروم برای تقویت جستجوی گوگل

سال ۲۰۰۵، گوگل clickstream کامل میلیاردها کاربر اینترنتی رو میخواست و حالا با کروم، به اون دست پیدا کرده. اسناد API نشون میده که گوگل چندین نوع معیار رو محاسبه میکنه که میتونن با استفاده از بازدیدهای کروم مربوط به صفحات فردی و کل دامنهها فراخوانی بشن.

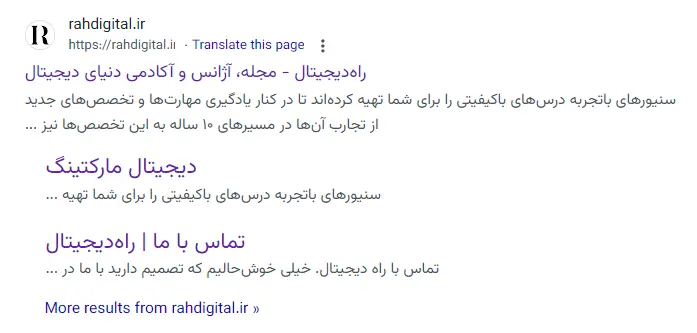

این سند که ویژگیهای مربوط به نحوه ایجاد Sitelinks توسط گوگل رو شرح میده، جالبه. یه فراخوانی به نام topUrl رو نشون میده که «لیستی از URLهای برتر با بالاترین امتیاز two_level_score، یعنی chrome_trans_clicks» هست.

احتمالاً از تعداد کلیکها روی صفحات در مرورگرهای کروم استفاده میکنه و از اون برای تعیین محبوبترین/مهمترین URLهای یه سایت استفاده میکنه که وارد محاسبه اینکه کدومها رو تو ویژگی sitelinks قرار بده میشه.

به عنوان مثال، در اسکرینشات بالا از نتایج گوگل، صفحاتی مانند «دیجیتال مارکتینگ»، «تماسباما» پربازدیدترین صفحات ما هستن و گوگل این رو از طریق ردیابی clickstreamهای میلیاردها کاربر کروم میدونه.

شماره ۳: لیستهای سفید در سفر، کووید و سیاست

یه ماژول در مورد «سایتهای سفر با کیفیت خوب» خوانندگان رو به این نتیجه میرسونه که یه لیست سفید برای گوگل در بخش سفر وجود داره «مشخص نیست که این فقط برای تب جستجوی سفر «همون travel» گوگل هست یا جستجوی وب هم شاملش میشه».

ارجاعات در چندین مکان به پرچمهای «isCovidLocalAuthority» و «isElectionAuthority» بیشتر نشون میده که گوگل در حال فهرست کردن دامنههای خاصیه که برای نمایش برای کوئریهای بسیار بحثبرانگیز یا بالقوه مشکلساز مناسبه.

مثل قبل که اشاره کردیم گوگل لیستی از سایتهایی داره که به شکل ویژه به اونها ترافیک بیشتری ارسال میکنه، احتمال داره که برخی از سایتها مثل ویکیپدیا در همین لیستهای سفید باشن.

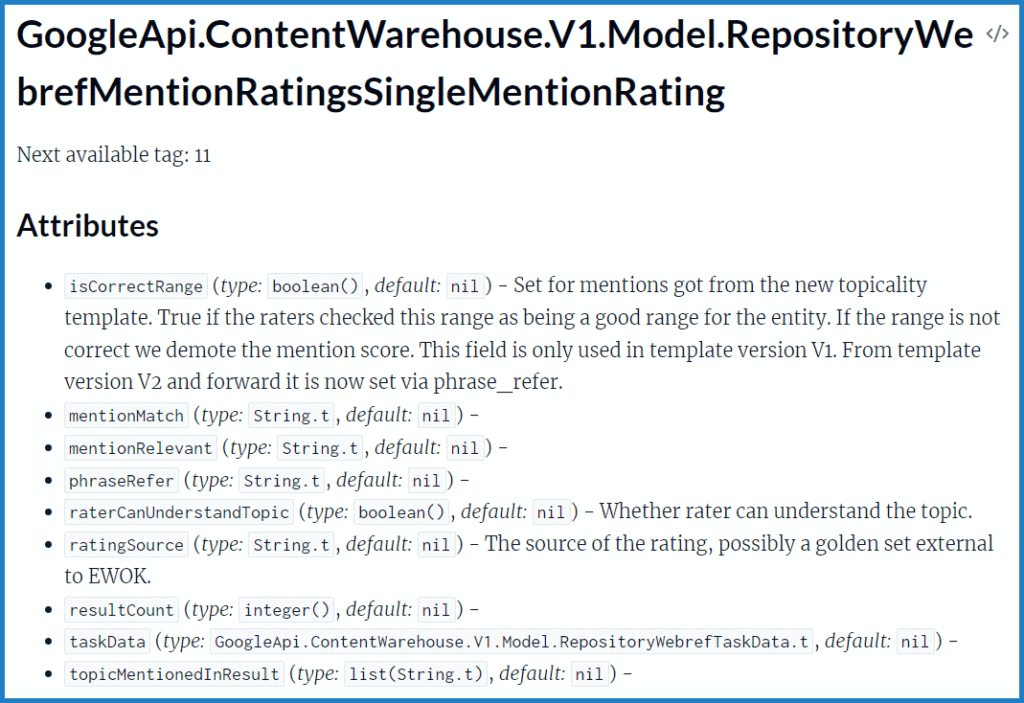

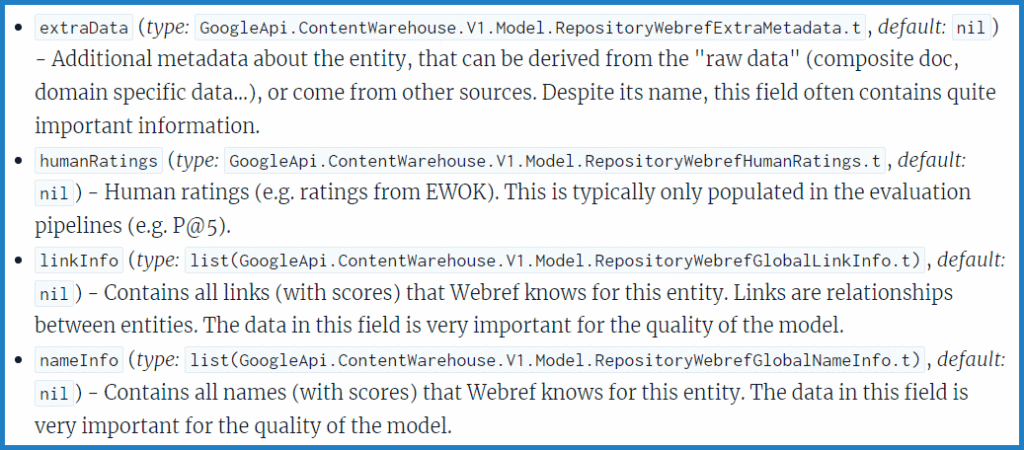

شماره ۴: استفاده از بازخورد ارزیابهای کیفیت

گوگل مدتهاست که یه پلتفرم رتبهبندی کیفیت به نام EWOK داره «Cyrus Shepard، یه رهبر برجسته در حوزه سئو هست و چندین سال به این پلتفرم کمک کرده.

اینکه این سیگنالهای مبتنی بر ارزیاب چقدر تأثیرگذار هستن و دقیقاً برای چه مواردی استفاده میشن، مشخص نیست. چیزی که جالبه این هست که نمرات و دادههای تولید شده توسط ارزیابهای کیفیت EWOK ممکنه به طور مستقیم در سیستم جستجوی گوگل دخیل باشن، نه اینکه صرفاً یه مجموعه آموزشی برای آزمایشها باشن. البته، ممکنه که اینها «فقط برای آزمایش» باشن، اما وقتی در اسناد لو رفته میگردید، میبینید که به طور خاص در یادداشتها و جزئیات ماژول ذکر شده.

این یکی به «رتبهبندی ارتباط در سطح سند» که از ارزیابیهای انجام شده از طریق EWOK به دست اومده اشاره میکنه. هیچ توضیح مفصلی وجود نداره، اما خیلی منطقیه که تصور کنیم این ارزیابیهای انسانی از وبسایتها چقدر مهم هستن.

این یکی به «رتبهبندیهای انسانی (به عنوان مثال رتبهبندیها از EWOK)» اشاره میکنه و خاطرنشان میکنه که اونها «معمولاً فقط در خطوط انتقال ارزیابی تکمیل میشن»، یعنی نشون میده که ممکنه در درجه اول دادههای آموزشی در این ماژول باشن.

شماره ۵: گوگل از دادههای کلیک برای تعیین نحوه وزندهی به لینکها در رتبهبندی استفاده میکنه

گوگل سه سطل/طبقه برای طبقهبندی شاخصهای لینک خودش داره (کیفیت پایین، متوسط، بالا). از دادههای کلیک برای تعیین اینکه یه سند به کدوم طبقه شاخص نمودار لینک تعلق داره استفاده میشه. به SourceType در اینجا و TotalClicks در اینجا مراجعه کنید.»

خلاصه:

- اگه Forbes.com/Cats/ هیچ کلیکی نداشته باشه، وارد فهرست کم کیفیت میشه و لینک نادیده گرفته میشه.

- اگه Forbes.com/Dogs/ حجم بالایی از کلیکها از دستگاههای قابل تأیید (همه دادههای مربوط به کروم که قبلاً مورد بحث قرار گرفت) داشته باشه، وارد فهرست با کیفیت بالا میشه و لینک سیگنالهای رتبهبندی رو منتقل میکنه.

- وقتی لینکی «قابل اعتماد» شد، چون به یه فهرست ردهبندی بالاتر تعلق داره، میتونه PageRank و anchorها رو منتقل کنه یا توسط سیستمهای هرزنامه لینک فیلتر/تنزل پیدا کنه.

- لینکهای فهرست لینکهای بیکیفیت به رتبهبندی سایت آسیبی نمیرسونه؛ اونها فقط نادیده گرفته میشن.

توضیح: منظور این هست که صفحات باکیفیت میتونن به سایر صفحات داخلی و خارجی اعتبار بدن و صفحات بیکیفیت به لینکهای داخلی و خارجی ضرر و آسیب نمیرسونن و صرفا نادید گرفتن میشن.

البته از نظر سئو ممکنه اگر با اهداف فریب و در تعداد انبوه باشه باعث جریمه بشه.

برند از هر چیز دیگری مهمتر است

گوگل روشهای زیادی برای شناسایی، مرتبسازی، رتبهبندی، فیلتر کردن و استفاده از entities داره. Entities شامل برندها «نامهای تجاری، وبسایتهای رسمیشون، حسابهای شبکههای اجتماعی مرتبط و غیره» میشن، اونا در یه مسیر اجتنابناپذیر به سمت رتبهبندی انحصاری و ارسال ترافیک به برندهای بزرگ و قدرتمندی که بر وب تسلط دارن، در مقابل سایتها و کسبوکارهای کوچیک و مستقل، قرار گرفتن.

توضیح: «اهمیت گوگل به برند باعث شده که به شکل اجتنابناپذیری برندهای بزرگ و معروف در صفحات اول گوگل باشن و این رقابت رو برای سایتها و کسبوکارهای کوچیک سخت میکنه، به همین دلیله که مهمه روی برند خودتون کار کنید و مجزا از سایت یک برند معروف داشته باشید.»

تجربه، تخصص، اعتبار، و قابل اعتماد بودن «E-E-A-T»

تجربه، تخصص، اعتبار، و قابل اعتماد بودن «E-E-A-T» ممکنه به طور مستقیم همونطور که برخی از سئوکارها فکر میکنن، مهم نباشه.

تنها اشارهای که الان به «مرجعیت موضوعی» «topical expertise» در این نشت اطلاعات پیدا کردیم، یه یادداشت مختصر در مورد مشارکتهای بررسی Google Maps هست. جنبههای دیگه E-E-A-T یا پنهان، غیرمستقیم، به روشهایی که شناسایی اونها سخته برچسبگذاری شدن، یا به احتمال زیاد با چیزهایی که گوگل ازشون استفاده میکنه و بهشون اهمیت میده مرتبط هستن، اما عناصر خاصی از سیستمهای رتبهبندی نیستن.

همونطور که مایک در مقالهاش اشاره کرد، اسنادی در این نشت اطلاعات وجود داره که نشون میده گوگل میتونه نویسندگان رو شناسایی کنه و با اونها به عنوان entities در سیستم رفتار کنه. افزایش نفوذ یه نفر به عنوان نویسنده در فضای آنلاین ممکنه در واقع منجر به مزایای رتبهبندی در گوگل بشه. اما اینکه دقیقاً چه چیزی در سیستمهای رتبهبندی «E-E-A-T» رو تشکیل میده و این عناصر چقدر قدرتمند هستن، یه سوال باز هست. شاید E-E-A-T، ۸۰ درصد پروپاگاندا و ۲۰ درصد ماهیت باشه. برندهای قدرتمند زیادی وجود دارن که در گوگل رتبه بسیار خوبی دارن و تجربه، تخصص، اعتبار یا قابل اعتماد بودن بسیار کمی دارن، همونطور که مقاله اخیر وایرال HouseFresh به طور عمیق به این موضوع میپردازه.

توضیح: در واقع ممکنه E-E-A-T اونقدر که مهم نشون داده میشه نباشه و البته بیاهمیت هم نیست اما از فاکتورهای کمتاثیر به حساب میاد.

محتوا و لینکها وقتی که قصد کاربر در مورد navigation و الگوهایی که ایجاد میکنه وجود داره، ثانویه هستن.

این یه یافته از تحلیل مایک هست. به نظر میرسه که PageRank هنوز جایی در ایندکس کردن و رتبهبندی جستجو داره، اما تقریباً مطمئناً از مقاله اصلی سال ۱۹۹۸ هست. نشت این سند به نسخههای متعدد PageRank (rawPagerank، یه PageRank منسوخ شده که به «nearest seeds» ، firstCoveragePageRank» از زمانی که سند برای اولین بار ارائه شد اشاره میکنه که در طول سالها ایجاد و کنار گذاشته شدن. و لینکهای anchor text، در حالی که در این نشت اطلاعات وجود دارن، به نظر نمیرسه خیلی فراگیر و حیاتی باشن.

برای اکثر کسبوکارهای کوچیک و متوسط و سازندگان/ناشران جدیدتر، سئو احتمالاً بازده کمی داره تا زمانی که به یک شهرت قوی در بین مخاطبهاشون برسن، یا همون مسئله هدف جستجو رو درست کنن.

در اینجا لازمه دوباره یادمون بیاد که برندهای بزرگ از قبل برنده هستن.

اگه در تلاش هستید با برندهای بزرگ رقابت کنید بعیده که صرفا با تولید محتوای خوب و رعایت نکات دیزاین بتونید توی گوگل رتبهبگیرید.

کاهش اهمیت عوامل رتبهبندی کلاسیک مانند PageRank، anchor، با این حال همچنان مهم هستند

به عنوان مثال، فرض کنید افراد زیادی در منطقه تهران «پارک آبی» رو جستجو میکنن و تا صفحه ۲، ۳ یا ۴ نتایج جستجو اسکرول میکنن تا زمانی که سایت رسمی خرید بلیط در تهران رو پیدا و روی اون کلیک کنن، گوگل خیلی سریع یاد میگیره که این چیزیه که جستجوگران این کلمات در اون منطقه میخوان.

اینجاست که ممکنه کلمهای مثل «پارک آبی» در سایت محبوب گوگل یعنی ویکیپدیا وجود داشته باشه ولی گوگل تصمیم میگیره اینبار ویکیپدیا رو کنار بذاره و سایتهایی رو لیست کنه که به خرید بلیط منجر بشن.

با بسط دادن این مثال به کل وب میتونیم بفهمیم که اگه بتونیم برای کلماتی که در گوگل جستجو میشن هدف ایجاد کنیم تا در نهایت روی سایت ما کلیک کنن احتمالا نیازی به روشهای on-page و off-page مثل لینکها و خرید رپورتاژ و … نداشته باشید.

در واقع Navboost ممکنه قویترین الگوریتم رتبهبندی در گوگل باشه، همونطور که الکساندر گروشِتسکی، معاون گوگل، در یه ایمیل در سال ۲۰۱۹ به سایر مدیران گوگل (از جمله دنی سالیوان و پاندو نایاک) گفت:

«ما قبلاً میدونیم که یه سیگنال میتونه از کل سیستم در یه معیار خاص قویتر باشه. به عنوان مثال، من کاملاً مطمئنم که Navboost بهتنهایی روی «کلیکها و احتمالاً حتی در معیارهای دقت/کاربردی» مثبتتر از بقیه رتبهبندیها بوده و هست. مهندسان خارج از تیم Navboost قبلاً از قدرت Navboost و این واقعیت که «پیروزیها رو میدزدید» هم ناراضی بودن»

کسانی که به دنبال تایید بیشتر هستن، میتونن رزومه مفصل پل هار، مهندس گوگل، رو بررسی کنن که میگه:

«من مدیر پروژههای رتبهبندی مبتنی بر گزارش هستم. تلاشهای تیم در حال حاضر بین چهار حوزه تقسیم شده:

۱) Navboost. این در حال حاضر یکی از قویترین سیگنالهای رتبهبندی گوگل هست. کار فعلی روی اتوماسیون، ساخت دادههای جدید navboost هست»

برای اکثر کسبوکارهای کوچیک، متوسط و یا جدید، سئو احتمالاً بازده کمی دارد

این یه یافته از تحلیل مایک هست. به نظر میرسه که PageRank هنوز جایی در ایندکس کردن و رتبهبندی جستجو داره، اما تقریباً مطمئناً از مقاله اصلی سال ۱۹۹۸ هست. نشت این سند به نسخههای متعدد PageRank (rawPagerank، یه PageRank منسوخ شده که به «nearest seeds» ، firstCoveragePageRank» از زمانی که سند برای اولین بار ارائه شد اشاره میکنه که در طول سالها ایجاد و کنار گذاشته شدن. و لینکهای anchor text، در حالی که در این نشت اطلاعات وجود دارن، به نظر نمیرسه خیلی فراگیر و حیاتی باشن.

برای اکثر کسبوکارهای کوچیک و متوسط و سازندگان/ناشران جدیدتر، سئو احتمالاً بازده کمی داره تا زمانی که به یک شهرت قوی در بین مخاطبهاشون برسن، یا همون مسئله هدف جستجو رو درست کنن.

در اینجا لازمه دوباره یادمون بیاد که برندهای بزرگ از قبل برنده هستن.

اگه در تلاش هستید با برندهای بزرگ رقابت کنید بعیده که صرفا با تولید محتوای خوب و رعایت نکات دیزاین بتونید توی گوگل رتبهبگیرید.

آپدیت: در ادامه لیست ۱۲ سیگنال رتبهبندی مهم پیدا شده در این اسناد را مطالعه خواهید کرد.

۱. گوگل احتمالاً لینکهایی که از منبع مرتبط نیستند رو نادیده میگیرد

ارتباط موضوعی «Relevancy» مدتهاست که داغترین موضوع دنیای سئو به حساب میاد، از چیزاییه که هیچوقت اندازهگیریش آسون نبوده، بالاخره، ارتباط موضوعی واقعاً چی هست؟

آیا گوگل لینکهایی داخل محتوای غیرمرتبط رو نادیده میگیره؟

اسناد لو رفته قطعاً نشون میده که اینطوره.

ما یه anchorMismatchDemotion واضح رو میبینیم که در ماژول CompressedQualitySignals بهش اشاره شده:

در حالی که ما زمینه اضافی کمی داریم، چیزی که میتونیم استنباط کنیم اینه که وقتی عدم تطابق وجود داره، امکان کاهش رتبه «نادیده گرفتن» لینکها وجود داره. میتونیم فرض کنیم که این به معنای عدم تطابق بین صفحات منبع و هدف، یا صفحه منبع و دامنه هدف هست.

این عدم تطابق میتونه چی باشه، جز ارتباط موضوعی؟

بهویژه وقتی در نظر بگیریم که در همین ماژول، یه ویژگی topicEmbeddingsVersionedData رو هم میبینیم.

embeddings موضوعی معمولاً در پردازش زبان طبیعی «NLP» به عنوان راهی برای درک معنایی موضوعات در یه سند استفاده میشه.

همچنین میبینیم که به یه ویژگی webrefEntities در ماژول PerDocData اشاره شده.

این چیه؟ اینها entities مرتبط با یه سند هستن.

ما نمیتونیم دقیقاً مطمئن باشیم که گوگل چطور ارتباط موضوعی رو اندازهگیری میکنه، اما میتونیم کاملاً مطمئن باشیم که anchorMismatchDemotion شامل نادیده گرفتن لینکهایی میشه که از منابع مرتبط نمیان.

نتیجه؟

ارتباط موضوعی باید بزرگترین تمرکز هنگام کسب لینک باشه، که نسبت به تقریباً هر معیار یا اندازهگیری دیگهای در اولویت قرار میگیره.

۲. لینکهای مرتبط به صورت محلی «از همان کشور» احتمالاً باارزشتر از لینکهای کشورهای دیگر هستند

ماژول AnchorsAnchorSource، به ما بینشی در مورد سورس لینکهایی که میگیریم میده، و نشون میده برای گوگل مهم لینکی که میگیریم ارتباط محلی داره یا نه.

تو این سند، یه ویژگی به نام localCountryCodes وجود داره که کشورهایی رو که صفحه به اونها محلی و/یا مرتبطترین هست، ذخیره میکنه.

یعنی وقتی سایت شما فارسی زبان هست، احتمالا گرفتن لینک از سایتهای انگلیسی زبان ارزش خیلی کمتری برای صفحه شما به حساب میاد به نسبت وقتی که از سایت فارسی زبان لینک میگیرید.

این ارزش حتی وقتی بیشتر میشه که از هم/کشور خودتون لینک بگیرید، یعنی اگه مخاطب سایت شما ایرانیها هستن پس از سایتهای ایرانی لینک بگیرید.

البته معنیش این نیست که سایر لینکها هیچ وزنی ندارن ولی این وزن بیشتر لینکهای محلی رو نشون میده که خب کاملا منطقی هست.

برای توضیح بیشتر خوبه یادمون بمونه که گوگل پیش خودش اینرو ذخیره میکنه که سایت شما برای چه کشوری هست، قبلا هم گفته بود وقتی از پسوندهای دامنه خاص کشورها استفاده میکنید پس پیشفرض احتمال میده برای اون کشور هستید، مثلا اگر دامنه سایت شما ir هست گوگل میدونه که سایت شما برای ایران هست.

۳. گوگل یک امتیاز اعتبار در سطح سایت دارد، با وجود اینکه ادعا میکند معیاری مثل DA یا DR در گوگل نیست

شاید بزرگترین شگفتی برای اکثر سئوکارهایی که این اسناد رو میخونن این باشه که گوگل یه امتیاز «اعتبار سایت» داره، با وجود اینکه بارها و بارها اعلام کرده که معیاری مثل Domain Authority (DA) Moz یا Domain Rating (DR) Ahrefs نداره.

در سال ۲۰۲۰، جان مولر از گوگل اعلام کرد:

«فقط برای اینکه روشن باشه، گوگل هنگام crawl، ایندکس یا رتبهبندی جستجو، به هیچ وجه از Domain Authority استفاده نمیکنه.»

اما در اواخر اون سال، به یه معیار در سطح سایت اشاره کرد و در مورد Domain Authority گفت:

«من نمیدونم که آیا من اون رو به این شکل اعتبار مینامم، اما ما یه سری معیار داریم که بیشتر در سطح سایت هستن، یه سری معیار که بیشتر در سطح صفحه هستن»

به وضوح، در اسناد لو رفته، یه امتیاز SiteAuthority میبینیم.

با این حال، برای احتیاط، ما نمیدونیم که این حتی از راه دور با DA یا DR همسو هست یا نه. همچنین احتمالاً به همین دلیله که گوگل معمولاً به سوالات در مورد این موضوع به این شکل پاسخ داده.

DA Moz و DR Ahrefs امتیازهای مبتنی بر لینک هستن که بر اساس کیفیت و کمیت لینکها هستن.

من شک دارم که siteAuthority گوگل صرفاً مبتنی بر مبنای لینک باشه، با توجه به اینکه به PageRank نزدیکتر به نظر میرسه. من بیشتر مایلم پیشنهاد کنم که این یه نوع امتیاز محاسبهشده بر اساس امتیازهای کیفیت در سطح صفحه، از جمله دادههای کلیک و سایر سیگنالهای NavBoost هست.

در واقع نامها ممکنه شبیه باشن ولی با احتمال بالا گوگل فاکتورهای زیادی رو برای اعتبار سایت و اعتبار صفحه میسنجه.

۴. لینکهای صفحات جدیدتر با ارزشتر از لینکهای صفحات قدیمیتر هستند

یه یافته جالب اینه که به نظر میرسه لینکهای صفحات جدیدتر، در برخی موارد، قویتر از لینکهای محتوای قدیمیتر وزن میشن.

چیزی که در اینجا برجستهست، اشاره به محتوای تازه منتشر شده «freshdocs» به عنوان یه مورد خاص و در نظر گرفتن اون به عنوان همون لینکهای «با کیفیت بالا» هست.

این احتمالا از فاکتورهایی باشه که بیشتر در سایتهای خبری و فید اهمیت پیدا کنه و نشون میده ارزش این صفحات برای گوگل نسبت به پستهای قدیمی بیشتر هست.

البته باید در نظر بگیریم که «صفحه جدید» به معنی «صفحه با کیفیتتر» نیست و این صرفا یکی از صدها و شاید هزاران الگوریتم صفحات هست.

احتمالا همین دلیلی هست که تمام سئوکاران در دنیا پیشنهاد میدن همیشه تولید محتوای جدید داشته باشید و «موتور سایت»رو روشن نگهدارید.

۵. اعتماد بیشتر گوگل به صفحه اصلی سایت به معنای اعتبار بیشتر لینکهای داخل این صفحه است

ما در این اسناد «دوباره، در ماژول AnchorsAnchorSource» به یه ویژگی به نام homePageInfo اشاره میکنیم که نشون میده گوگل میتونه منابع لینک رو به عنوان غیرقابل اعتماد، تا حدی قابل اعتماد یا کاملاً قابل اعتماد برچسبگذاری کنه.

این ویژگی مربوط به مواردی هست که صفحه منبع، صفحه اصلی یه وبسایت هست، و مقدار not_homepage به صفحات دیگه اختصاص داده میشه.

پس این میتونه به چه معنا باشه؟

خب این نشون میده گوگل الگوریتمهایی داره که میتونه تعریفی از «اعتماد» یک صفحه داشته باشه، نمیدونیم این الگوریتمها چی هستن ولی میدونیم صفحات داخلی میتونن این اعتماد رو از صفحه اصلی به ارث ببرن.

۶. گوگل به طور خاص لینکهایی که از سایتهای خبری با کیفیت بالا میآیند را برچسبگذاری میکند

جالب اینجاست که ما متوجه شدیم که وقتی یه لینکی از یه سایت «خبری، با کیفیت بالا» میاد، گوگل اطلاعات بیشتری در مورد اون ذخیره میکنه.

آیا معنیش اینه که لینکهای سایتهای خبری «به عنوان مثال، نیویورک تایمز، گاردین و …» با ارزشتر از لینکهای سایر انواع سایتها هستن؟

ما به طور قطع نمیدونیم.

اما وقتی به این موضوع نگاه میکنیم، در کنار این واقعیت که این نوع سایتها معمولاً معتبرترین و قابل اعتمادترین نشریات آنلاین هستن، و همچنین اونهایی که از نظر تاریخی در دنیای قدیم PageRank ۹ یا ۱۰ داشتن، شما رو به فکر فرو میبره.

به عنوان یه سناریو اگه اینو کنار ارزش بالای لینک گرفتن از سایتهای خبری بذاریم که معمولا داخل اونها معرفی کردن سایتهای دیگه و لینک دادن طبیعی هست نشون میده در کل لینک گرفتن از سایتهای خبری احتمالا ارزش بیشتری به نسبت لینکهای دیگه داره.

البته مجدد باید بگیم که ما به طور قطع نمیدونیم.

۷. لینک گرفتن از seed siteها احتمالا با ارزشترین روش جذب لینک باشد

اگه بخوایم یه تعریف خوب برای seed site ها بگیم یعنی «سایتها و مجموعههای قابل اعتماد که به سایتهای دیگه متصل باشن، تعداد زیادی لینک خروجی مفید داشته باشن تا شناسایی صفحات مفید و باکیفیت دیگه رو تسهیل کنن و به عنوان «هاب» در وب عمل کنن.

مثلا توی دنیای وب ما ویکیپدیا رو یه seed میشناسیم، یا شاید بزرگترین seed موجود هست. گوگل در کنار اینکه این سایتهارو دوست داره، به لینکهایی که به بقیه هم میدن نگاه میکنه.

اسناد لو رفته نشون میده که PageRank به شکل اصلی خودشون مدتهاست که منسوخ شده و با PageRank-NearestSeeds جایگزین شده.

۸. گوگل احتمالاً از «منابع معتبر» برای محاسبه اسپم بودن لینک استفاده میکند

وقتی به ماژول IndexingDocjoinerAnchorSpamInfo نگاه میکنیم، ماژولی که میتونیم فرض کنیم مربوط به نحوه پردازش لینکهای اسپم هست، به «منابع معتبر» اشاره میکنیم.

به نظر میرسه که گوگل میتونه احتمال اسپم بودن لینکرو بر اساس تعداد منابع معتبری که به یه صفحه لینک میدن محاسبه کنه.

ما نمیدونیم که «منبع معتبر» منظورش چیه، اما وقتی به طور کلی در کنار یافتههای دیگهمون بهش نگاه کنیم، میتونیم فرض کنیم که این میتونه بر اساس اعتماد «صفحه اصلی» باشه. که بازم نمودیم دقیقا چطور گوگل به صفحه اصلی ما اعتماد میکنه.

خلاصه این موضوع اینه که وقتی از جاهایی لینک میگیرید که لینک خاصی به اونها نیست گوگل احتمال میده که اسپم باشه، به خاطر همینه که من شخصا پیشنهاد میدم وقتی از جایی لینک میگیرید مثلا رپورتاژ میخرید سعی کنید برای خود رپورتاژ هم لینک تهیه کنید و حتما که این لینکها باید ارزشمند باشن.

۹. گوگل با اندازهگیری سرعت لینک، حملات سئوی منفی را شناسایی میکند

جامعه سئو مدتیه بر سر اینکه آیا حملات سئوی منفی یه مشکل هست یا نه، اختلاف نظر داره. گوگل مصره که میتونه چنین حملاتی رو شناسایی کنه، در حالی که بسیاری از سئوکارها ادعا کردن که سایتشون تحت تأثیر منفی این موضوع قرار گرفته.

این اسناد به ما بینشی در مورد اینکه گوگل چطور سعی میکنه چنین حملاتی رو شناسایی کنه، میده، از جمله ویژگیهایی که موارد زیر رو در نظر میگیرن:

- مدت زمانی که لینکهای اسپم شناسایی شدن.

- میانگین نرخ روزانه اسپم کشف شده.

- زمان شروع یه جهش.

ممکنه که این موضوع لینکهایی که قصد دارن سیستمهای رتبهبندی گوگل رو دستکاری کنن رو هم در نظر بگیره، اما اشاره به «spike هرزنامه anchor» نشون میده که این مکانیزم برای شناسایی حجمهای قابل توجه هست، چیزی که ما میدونیم یه مشکل رایج در حملات سئوی منفی هست.

احتمالا گوگل فقط به جهش لینکهای اسپمی که به سایتتون میزنن نگاه نکنه و فاکتورهای دیگهای هم براش مهم باشه، اما بیشتر این حملهها به همین شکله، حجم زیادی لینکهای اسپم از سایتهای ضعیف رو به صفحات سایتتون میزنن و سعی میکنن شمارو از صفحه اول گوگل پایین بکشن.

۱۰. پنالتیها یا adjustments مبتنی بر لینک

به نظر میرسه که گوگل این توانایی رو داره که پنالتیهای اسپم لینک رو اعمال کنه یا لینکها رو به صورت link-by-link یا all-links نادیده بگیره.

این میتونه به این معنی باشه که با توجه به یک یا چند سیگنال تایید نشده، گوگل میتونه تعیین کنه که آیا همه لینکهای اشاره شده به یه صفحه رو نادیده بگیره یا فقط برخی از اونها رو.

شاید این سوال برامون پیش میاد که اگه صفحه مثلا ۱۰۰ لینک اسپم و ۱۰ لینک باکیفیت داشته باشه ایا ممکنه گوگل تمام لینکهای اون صفحه رو نادیده بگیره، خب از نظر احتمال ممکنه با این حال ما نمیدونیم دقیقا باید چه نسبتی باشه که گوگل تصمیم به نادیده گرفتن کنه.

این بیشتر نشون میده که مراقب این باشید تعداد لینکهای اسپم صفحات سایت شما زیاد نشه چون ۱ درصد این احتمال وجود داره که لینکهای اسپم روی لینکهای باکیفیت تاثیر داشته باشن.

۱۱. لینکهای سمی وجود دارند

همین ماه گذشته، مولر گفت که لینکهای سمی یه مفهوم ساختگی هستن:

«مفهوم لینکهای سمی توسط ابزارهای سئو ساخته شده تا شما به طور منظم به اونها پول بدید.»

با این حال، در این اسناد، میبینیم که به «BadBackLinks» اشاره شده.

اطلاعات ارائه شده در اینجا نشون میده که یه صفحه میتونه به دلیل داشتن بک لینکهای «بد» جریمه بشه.

در حالی که ما نمیدونیم چطوری یا اینکه روش امتیاز منفی این لینکها توسط گوگل چقدر به ابزارهای سئو نزدیک هست. حداقل یه معیار بولی «معمولاً مقادیر درست یا غلط» وجود داره که آیا یه صفحه لینکهای بدی داره که به اون اشاره میکنه یا نه.

اینها نشون میده که هنوز بکلینکهای بد و سمی وجود دارن و هنوز میتونن اثر منفی داشته باشن و لازمه که بابت اونها کاری انجام بشه.

۱۲. محتوای اطراف لینک، به همراه anchor text، اهمیت زیادی دارد

سئوکارها مدتهاست که از anchor text لینکها به عنوان راهی برای ارائه سیگنالهای زمینهای صفحه هدف استفاده میکنن و مستندات Search Central گوگل در مورد بهترین شیوههای لینک تایید میکنه که «این متن به مردم و گوگل چیزی در مورد صفحهای که به اون لینک میدید، میگه.»

اما اسناد لو رفته هفته گذشته نشون میده که فقط anchor text نیست که برای درک زمینه یه لینک استفاده میشه. احتمالاً از محتوای اطراف لینک هم استفاده میشه.

این اسناد به context2، fullLeftContext، و fullRightContext اشاره میکنن که اصطلاحات نزدیک لینک هستن.

این نشون میده که محتوای اطراف لینک اهمیت بیشتری نسبت به anchor text داره.

در واقع بهتره سعی کنید در مرتبطترین پاراگراف لینک بدید که ارزش اون به مراتب بیشتر هست.

نکات کلیدی

آیا لینکها هنوز مهم هستن؟

قطعاً میگم بله.

شواهد زیادی در اینجا وجود داره که نشون میده لینکها هنوز سیگنالهای مهم رتبهبندی هستن «با وجود اینکه ما از این نشت نمیدونیم دقیقا کدوم سیگنالها مهم هستن یا چه وزنی دارن».

شاید بزرگترین نکته این اسناد این باشه که ارتباط موضوعی خیلی مهمه. این احتماله که گوگل لینکهایی رو که از صفحات مرتبط نمیان نادیده میگیره، و این رو به یه معیار اولویت موفقیت برای سازندگان لینک و سئوکاران تبدیل میکنه.

اما فراتر از این، ما درک عمیقتری از اینکه گوگل چطور به طور بالقوه برای لینکها ارزش قائل میشه و چیزهایی که میتونن قویتر از بقیه وزن بشن، به دست آوردیم.

آیا این یافتهها باید نحوه رویکرد شما به لینکسازی یا روابط عمومی دیجیتال رو تغییر بده؟

این بستگی به تاکتیکهایی داره که استفاده میکنید.

اگه هنوز از تاکتیکهای قدیمی برای کسب لینکهای با کیفیت پایینتر استفاده میکنید، پس میگم بله.

اما اگه تاکتیکهای کسب لینک شما مبتنی بر کسب لینک با از منابع معتبر و با کیفیت بالا هست پس احتمالا راهرو دارید درست میرید. نکته اصلی این بود که مرتبط لینک بگیرید.

سورس اسناد: به نظر میرسه این API در نسخههای مختلفی هست، مثلا هر منبعی نسخهای از اون رو بررسی کرده با این حال میتونید در لینکهای زیر اونهارو پیدا کنید.

منبع ۰.۳ / منبع ۰.۴ / منبع ۰.۵

توضیح: این صفحه به صورت منظم با منتشر شدن چیزهای بیشتر از این اسناد آپدیت خواهد شد.

یک دیدگاه حرفهای برامون بفرستید، خوشحال میشیم و حتما همگی میخونیم.